Los bots, el tráfico de Internet realizado por máquinas y no por humanos, es hoy en día un problema enorme, en gran medida como fruto del aumento del web scrapping o rascado de contenidos, que es una técnica dirigida a extraer información de páginas web de manera automatizada. En los últimos tiempos ha aumentado considerablemente por obra y gracia de las empresas de inteligencia artificial (AI) generativa. ¿Qué hacer al respecto? Vamos a arrojar algo de luz sobre el asunto.

Cambia de CMS gratis con expertos

¿Tu CMS te tiene desesperado?

Cambia a un nuevo CMS, con inteligencia artificial (IA), e incluso ahorra. Los expertos de CMS MAG te asesoran gratis:

Según una publicación de Brightspot, basado en un estudio de Imperva, el problema de los bots es ahora creciente y está llegando a unos límites bastante insoportables. Son muchos los parásitos que se apuntan a la moda de coger prestados los contenidos para, si es posible, sacar dinero con ellos a nuestras espaldas.

Ya no estamos en primero de Internet, los creadores de contenidos llevamos ya aquí unas décadas y no deberíamos ser aquellos ingenuos que proporcionaron el acceso a los contenidos gratis a aquellos que supuestamente iban a ordenar el contenido global en beneficio de todos y no solo en el suyo propio.

Existen formas de defenderse, la más popular es hacerlo en el archivo robots.txt, pero son muchas las empresas agresivas que lo ignoran total o parcialmente. Además, muchas de estas empresas son multinacionales y es muy posible que no se pueda actuar contra ellas al estar localizados en sitios recónditos. Otras, directamente, están defendidas por unos dirigentes ultra proteccionistas.

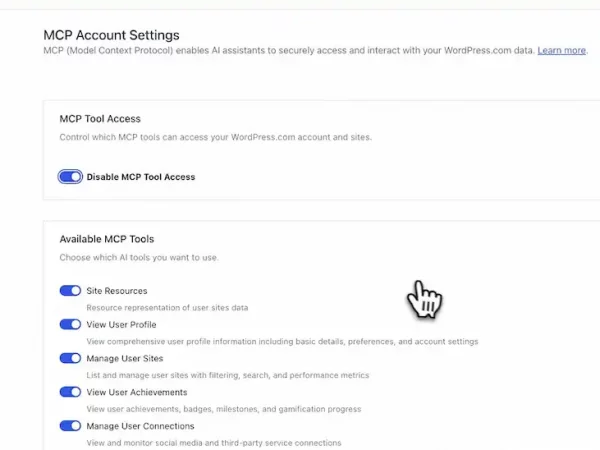

Lo mejor es tomar medidas más contundentes, reglas, a nivel de servidor, pero también en el CMS. Debe haber un sistema multicapa que pueda detectar y gestionar adecuadamente todo este tráfico automático. Algunos bots deben ser bloqueados, otros recibir la respuesta que les indique que deben pagar por rastrear y registrar los contenidos y otros, deben ser permitidos. Todo esto se debe combinar con diversas acciones legales según corresponda.

Como bien asegura Brightspot, este tráfico debe ser permanentemente monitorizado, puesto que ya se han dado casos en los que las empresas de IA falsean su user agent y nos visitan asegurando ser otro programa el que accede al contenido.

La decisión de dar acceso o no al contenido se debe tomar no solo atendiendo a criterios informáticos, sino también editoriales y de negocio.

Existen más razones para tomarse más en serio este tráfico, monitorizarlo y, en su caso bloquearlo. No solo roban el contenido, sino que también consumen gran cantidad de recursos de hosting que, a la postre, es dinero, presupuesto que se tira por el sumidero. Y además de degradar el servicio para los usuarios legítimos, también afecta negativamente a la analítica, de forma que la desvirtúa y no hace fácil tomar decisiones.

Según Brightspot, las principales herramientas de mitigación de bots reveló que la mayoría de las defensas perimetrales (CDN, WAF) presentan dificultades contra bots avanzados y, por ello, se hace necesaria protección a nivel de CMS. Además, está encima de la mesa el tema de los falsos positivos que pueden hacer mucho daño a la audiencia. Otra gran empresa que ya ha entendido esto y ha llegado a un acuerdo en este sentido es Arc XP.

Noticias relacionadas: Inteligencia artificial (IA)

Parece, por tanto, claro que las empresas de CMS no solo deben actuar empoderando al periodista, añadiendo IA para mejorar el contenido, sino también para protegerlo. Como hemos observado, son ya algunas las empresas que están sacando soluciones en este sentido integradas en el CMS ya que pueden ser vitales para defender efectivamente la propiedad intelectual.

Esto es especialmente necesario cuando empresas tan grandes como OpenAI comenzaron a llegar a grandes acuerdos con grupos mediáticos, pero el hecho de que otras empresas no estén respectando la propiedad intelectual, con Google a la cabeza, empresa que solo cuenta con acuerdo de IA con Reddit, está disuadiendo a las que actúan bien en este sentido. Estos sistemas, adicionalmente, añaden una capa más de seguridad a todo el entramado, algo que, como hemos visto recientemente, nunca está de más.

Deja una respuesta